KI-Agenten versprechen autonome Workflow-Automatisierung. Doch im Praxiseinsatz scheitern sie oft an Komplexitätsfallen. Entwickler kennen das: Gescheiterte Multi-Agent-Implementierungen. Unerwartete Framework-Limits. Governance-Probleme, die erst nach Go-Live auffallen. Unternehmen wie Salesforce und Microsoft zeigen hingegen: Produktionsreife Agenten-Systeme laufen 2026 einwandfrei – mit klugen Architektur-Entscheidungen.

Dieser Artikel nennt Tool-Stacks, die 2026 funktionieren. Er unterscheidet Enterprise-Plattformen von Developer-Frameworks. Und er beleuchtet Architektur-Muster für erfolgreiche Implementierungen. Basierend auf Framework-Analysen, Praxisberichten und Experten aus dem DACH-Raum. Konkrete Hilfestellungen für Entwickler und technische Entscheider.

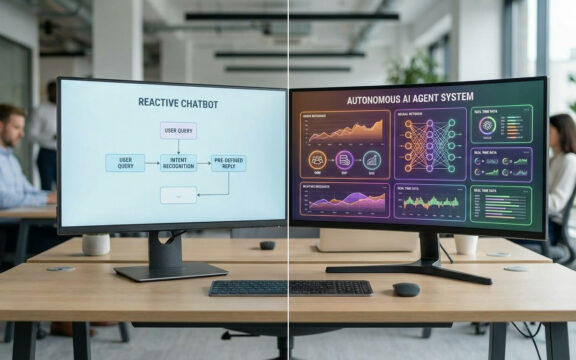

KI-Agenten vs. Chatbots: Die technischen Unterschiede

Der Kernunterschied: Chatbots reagieren in Single-Turn-Konversationen. KI-Agenten steuern autonome Multi-Step-Workflows.

Autonomie und Prozess-Komplexität

Chatbots warten auf Eingaben und spucken Antworten aus – vordefiniert oder LLM-generiert. Agenten laufen einen Agentenloop: Perception, Planning, Action, Observation. Iteration um Iteration. Aktuelle Analysen bestätigen: Damit wickeln Agenten mehrstufige Prozesse ohne Menschen ab.

Praxisbeispiel: Salesforce Agentforce bearbeitet Urlaubsanträge komplett autonom. Der Agent checkt SharePoint auf Verfügbarkeit. Validiert Genehmigungen via Microsoft Teams. Aktualisiert HR-Systeme. Ein manueller Prozess von 2-3 Tagen? Automatisiert in Stunden. Diese Orchestrierung trennt Agenten klar von Chatbots.

Systemintegration und Tool-Zugriff

Chatbots greifen auf statische Knowledge Bases zu. Agenten docken dynamisch in Enterprise-Systeme an. Via Function Calling (OpenAI Agents SDK) oder Tool-Integration-Layer (LangChain). APIs aufrufen. Datenbanken abfragen. Services triggern. Das fordert robuste Fehlerbehandlung und Security.

Architektur macht den Unterschied: Microsoft Copilot Studio liefert Konnektoren für SharePoint, Teams, Office 365. AutoGen braucht Custom-Code pro Service – höherer Aufwand.

Multi-Agent-Koordination

2026 gewinnt Multi-Agenten-Koordination an Fahrt. Agenten übernehmen Rollen, kommunizieren per Protokoll. CrewAI und AutoGen glänzen hier.

Problem: Komplexität explodiert. Agent-zu-Agent-Fehler sind hart zu debuggen. Kontextmanagement entscheidet. Latenode warnt zurecht: „Multi-Agent-Szenarien fügen eine weitere Ebene der Komplexität hinzu.“

Tool-Stack für KI-Agenten: Enterprise vs. Developer vs. No-Code

Der Tool-Stack bestimmt Geschwindigkeit, Wartbarkeit und Gesamtkosten. 2026 teilt sich der Markt in drei Kategorien. Jede mit eigenen Abwägungen.

Enterprise-Plattformen: Integration first

Salesforce- oder Microsoft-Nutzer kommen schnell ans Ziel. Salesforce Agentforce: €10.000-30.000 Einmalig plus €5.000+/Monat. Drag-and-Drop für Knoten. Native Docking an Sales Cloud, Service Cloud, Marketing Cloud.

ROI: Fünf eingesparte FTE à €50.000/Jahr amortisieren in 6-12 Monaten. Achtung: Vendor Lock-in. Agentforce klebt am Salesforce-Stack. Für Multi-Cloud oder Greenfield: Ausschlusskriterium.

Microsoft Copilot Studio passt ins Microsoft-Universum: SharePoint, Teams, PowerBI. Stärke: Nahtlose Integration. Schwäche: Wenig Flexibilität außerhalb.

Beam AI wirbt stack-agnostisch: Oracle, Salesforce, SAP. API-basiert, ohne Neubau. Aber Governance-Details fehlen.

Developer-Frameworks: Kontrolle und Flexibilität

KI-Teams mit Custom-Anforderungen wählen Code-Frameworks. LangChain dominiert bei dokumentenlastigen Workflows. Flexibel. Aber mittlere bis hohe Komplexität.

AutoGen (Microsoft Research) excelliert bei Multi-Agent-Dialogen. Relevant für kollaborative Systeme. Lernkurve steil: Rollen, Protokolle, verteilte Fehlerbehandlung.

CrewAI betont Team-Koordination. Ideal, wenn Agenten Expertise splitten – Code, Testing, Docs.

LlamaIndex integriert Datenquellen mit LLMs. Optimal für RAG und Kontext in wissensintensiven Projekten.

OpenAI Agents SDK: Schnelle Function Calls, persistenter Kontext. Limitation: OpenAI-Abhängigkeit. Für GPT-4-Nutzer der direkte Einstieg.

No-Code/Low-Code: Schnelligkeit vs. Skalierbarkeit

Latenode: Visuelle Flows plus JavaScript. Start mit Drag-and-Drop, Code bei Bedarf. Neu, Community klein.

Relevance AI: Intuitive UI für schnelle Agenten. Aber „nicht für komplexe Workflows“. Beam AI: „Mehr Task-Assistent als Operator.“

Langdock: Deutsch, Workflow-fokussiert. Niedriger Einstieg ohne KI-Expertise. Dokumentation dünn.

Schlussfolgerung: No-Code für Prototypes und Assistenten. Nicht für kritische Prozesse. Beam AI: „Begrenzte Funktionen für Enterprise-Compliance oder Governance.“

Praxis-Implementierungen: Was funktioniert wirklich

Theorie allein reicht nicht. Dokumentierte Fälle mit Ergebnissen zählen. Hier, wo Agenten 2026 Mehrwert bringen.

Beispiel 1: Automatisierte Urlaubsantrag-Verarbeitung

Wer: Großunternehmen im Salesforce-Ökosystem

Tool/Methode: Salesforce Agentforce mit Power Automate Flow-Integration

Anwendungsfall: Vollautomatische Verarbeitung von Urlaubsanträgen über mehrere Systeme hinweg

Implementierung: Agent nimmt Webformular an. Checkt SharePoint auf Verfügbarkeit. Schickt Teams-Anfragen an Manager. Bei Approval: HR-Update. Conditional Branching bei Konflikten – Eskalation an HR.

Ergebnis: Von 2-3 Tagen auf Stunden. Fehler minimiert durch Validierung von Resturlaub, Fristen, Kapazität. Setup: 8-12 Wochen für Integrationen.

Erkenntnis: Enterprise-Plattformen punkten bei regelbasierten Flows. Komplexität sitzt in der Integration, nicht der Logik. Ohne Salesforce-Know-how: Partner einplanen.

Beispiel 2: Meeting-Protokollierung und Dokumentation

Wer: AI FIRST (deutsches KI-Beratungsunternehmen)

Tool/Methode: Langdock Agenten mit automatischer Transkription

Anwendungsfall: Vollautomatische Protokollierung von Team-Meetings mit Speaker-Zuordnung und Dokumenten-Generierung

Implementierung: Echtzeit-Transkription. Speaker-Zuordnung. Strukturierte Mails oder Docs via LLM-Zusammenfassungen und Action-Items.

Ergebnis: „Automatische Meeting-Protokollierung ist ein riesiger Quick Win, weil es Zeit spart, Fokus auf den Termin erhöht und wertvolle Daten erzeugt“ – AI FIRST. 1-2 Stunden pro Meeting gespart bei 5+ wöchentlich. Bonus: Transkripte als Kontext für andere Agenten.

Erkenntnis: Audio-Qualität entscheidet. Ähnliche Stimmen verwirren Speaker-ID. Externe Mikros nutzen. Manuell reviewen vor kritischen Flows. Assistenz, keine volle Autonomie.

Typische Fehlerquellen und Komplexitätsfallen

Dokumentation und Praxis klaffen auseinander. Entwickler unterschätzen vier Bereiche systematisch.

Fehler 1: Falsche Tool-Auswahl basierend auf Marketing

Teams kaufen Feature-Listen. Relevance AI wirbt als Agent-Plattform. Beam AI: „Nicht für systemübergreifende Workflows.“ Folge: Prototyp ok, Production floppt.

Empfehlung: Definieren Sie Use Cases und Non-Functional-Requirements vorab. Testen mit realen Daten. Für Kritische: Enterprise oder Custom.

Fehler 2: Unterschätzung der Implementierungskomplexität

Latenode: „Komplexe Anforderungen und Lernaufwand bremsen Teams.“ LangChain: 4-8 Wochen für Python-Dev. AutoGen Multi-Agent: 8-12 Wochen.

No-Code verschiebt Komplexität – Debugging visuell ohne Logs ist mühsam.

Empfehlung: „Starten Sie mit einem Agenten im Tech-Stack und erweitern Sie schrittweise“ – Superchat. Small, measure, iterate.

Fehler 3: Governance und Compliance als Nachgedanke

No-Code schwächelt: Fehlende Audit-Logs, RBAC, DSGVO, Rollbacks.

Regulierte Branchen brauchen das zwingend. Klären Sie vor Tool-Wahl.

Fehler 4: Kontextmanagement und Persistenz

Agenten müssen Kontext über Sessions halten – Tage, Wochen. OpenAI: Native Threads. LangChain: Custom Stores wie Redis. Enterprise: Integriert.

Ohne das: Prozesse neu starten. Nutzerfrust.

Fehler 5: Multi-Agent-Koordination ohne Strategie

Spezialisierung klingt gut. Realität: „Weitere Komplexitätsebene.“ Protokolle definieren. Kaskadierende Fehler. Hartes Debugging.

AutoGen/CrewAI helfen. Aber: Single-Agent zuerst. Multi nur bei Bedarf.

Architektur-Muster für produktionsreife Agenten

Erfolgreiche Agenten folgen bewährten Mustern. Framework-übergreifend.

Pattern 1: Event-basierte Aktivierung mit Webhooks

Kein Polling. Webhooks triggern bei Events. Salesforce bei CRM-Eintrag. Copilot bei SharePoint-Update.

Vorteil: Niedrige Latenz, Kostenersparnis. Alle Frameworks supporten: LangChain via Handler, Enterprise nativ.

Pattern 2: Branching und Conditional Logic

Kontextbasierte Entscheidungen sind essenziell. Urlaubsbeispiel: Eskalation bei Konflikten, Auto-Approval sonst.

Enterprise: Visuelle Knoten. Code: If-Then in Python/JS. Testen Sie alle Branches, vor allem Edges.

Pattern 3: Retry-Logik und Rollback-Mechanismen

APIs failen. Retry mit Backoff. Kritische Fehler: Rückgängig machen.

Empfehlung: Idempotenz sicherstellen. States loggen. Circuit Breaker für Services.

Pattern 4: Hybrid-Ansatz für Komplexität

Latenode: Visuell starten, Frameworks integrieren bei Custom-Logik.

No-Code für Standards, Code für Transformationen/ML.

Tools, Preise und Entscheidungshilfen

Tool-Wahl hängt von Expertise, Budget, Komplexität ab. Tabelle fasst Kriterien zusammen.

| Kategorie | Tool | Preis | Setup-Zeit | Geeignet für | Limitierung |

|---|---|---|---|---|---|

| Enterprise | Salesforce Agentforce | €10k-30k + €5k+/Monat | 8-16 Wochen | Salesforce-Kunden mit komplexen Workflows | Lock-in ins Salesforce-Ökosystem |

| Enterprise | Microsoft Copilot Studio | In Microsoft 365 inkl. | 4-8 Wochen | Microsoft-zentrische Unternehmen | Begrenzt auf Microsoft-Stack |

| Enterprise | Beam AI | Nicht öffentlich | 2-4 Wochen | Systemübergreifende Workflows ohne Stack-Neuaufbau | Wenig Details zu Governance |

| Developer | LangChain | Open Source (kostenlos) | 4-12 Wochen | Dokumenten-intensive Workflows | Hohe Lernkurve |

| Developer | AutoGen | Open Source (kostenlos) | 8-12 Wochen | Multi-Agent-Kollaboration | Sehr hohe Komplexität |

| Developer | OpenAI Agents SDK | Pay-per-Use (API-Kosten) | 2-4 Wochen | Schnelle Integration moderner LLMs | Abhängigkeit von OpenAI |

| No-Code | Latenode | Hybrid-Modell | 1-2 Wochen | Schnelles Prototyping mit Code-Option | Noch relativ neu |

| No-Code | Relevance AI | SaaS-Preismodell | 1-2 Wochen | Interne Assistenten, kleine Teams | Nicht für kritische Prozesse |

Entscheidungsbaum:

- Existierender Stack: Salesforce → Agentforce | Microsoft → Copilot Studio

- Greenfield + Budget: Enterprise-Plattformen für schnelle Implementierung

- Greenfield + Expertise: Developer-Frameworks für maximale Kontrolle und niedrigere TCO

- Prototyping: No-Code-Plattformen für schnelles Testing

- Production-kritisch: Enterprise oder Custom-Development (keine No-Code-Tools)

Kontroverse: Autonomie vs. Kontrollierbarkeit

Trade-off: Volle Autonomie (AutoGPT, Claude Computer Use) oder kontrollierte Automation (Copilot Studio, OpenAI Actions).

Pro Autonomie: Superchat: „Claude Computer Use und AutoGPT bieten höchste Freiheit.“ Effizienz, weniger Mikromanagement.

Pro Kontrolle: Copilot und Actions einfacher, governance-stark. Unternehmen fordern Logs, Rollbacks. Autonomie riskiert Fehler und Compliance.

Einordnung: 2026 siegt Kontrolle in Enterprise. Autonomie für Forschung. Fehlerkosten in HR/Finanz überwiegen. Starten Sie kontrolliert, skalieren bei niedriger Fehlerrate.

Realistische Erwartungen: Was Agenten 2026 können und was nicht

Marketing übertrieben. Agenten reif für spezifische Fälle. Keine Alleskönner.

Was funktioniert:

- Standardisierbare Workflows mit klaren Regeln (Urlaubsanträge, Ticket-Routing)

- Dokumenten-Verarbeitung und Extraktion (Rechnungen, Verträge)

- Meeting-Protokollierung und Zusammenfassung

- System-zu-System-Integration mit etablierten APIs

- Einfache Multi-Step-Prozesse mit wenigen Branches

Was noch nicht zuverlässig funktioniert:

- Komplexe Entscheidungen mit unvollständigen Informationen

- Kreative Tasks ohne klare Erfolgskriterien

- Hochdynamische Umgebungen mit häufigen Prozessänderungen

- Multi-Agent-Systeme mit mehr als 3-4 spezialisierten Agenten

- 100% autonome Operation ohne menschliches Review

Fehlerquoten: Benchmarks rar. Bei Struktur: <5%. Unstrukturiert: 15-20%. Error-Handling und Human-in-the-Loop planen.

Fazit: Pragmatischer Einstieg in KI-Agenten

KI-Agenten liefern 2026 messbaren Nutzen bei strukturierten Flows. Erfolgsfaktoren:

- Tool-Auswahl nach Use Case: Enterprise für Stacks, Developer für Custom, No-Code für Prototypes.

- Start small, scale smart: Single-Agent für einen Workflow. Messen: Zeitersparnis, Fehlerreduktion. Dann expandieren.

- Governance von Tag 1: Logs, Rollbacks, Compliance einbauen.

- Realistische Fehlererwartung: Human-in-the-Loop für Kritik. 100% Autonomie kein Ziel.

Hürde: Integration, Fehlerbehandlung, Multi-Agent. Ohne Expertise: Hybrid (Latenode) oder Enterprise (Agentforce, Copilot). Langfristig: Frameworks für Kontrolle und TCO.

Pragmatisch: Repetitiven Flow wählen. Minimalen Agent bauen. 4-8 Wochen messen. Bei ROI: Iterieren. Skalieren. Wer den Tool-Stack richtig wählt und mit einer Architektur startet, die sich bewährt hat, vermeidet typische Fehler beim KI-Agent erstellen.