Automatisierung verspricht Effizienz. Bis der erste Workflow falsche Daten ins CRM spült oder wichtige E-Mails im Nichts landen. Anbieter werben mit „autonomen KI-Agenten“. Agenturen ringen stattdessen mit Fehlern in der Sentiment-Analyse, API-Limits und der Frage: Welche Prozesse eignen sich wirklich?

n8n als Low-Code-Plattform erleichtert seit 2024 den Einstieg in KI-Workflows für Agenturen – ohne eigenes Entwicklerteam. Stepstone kürzte Integrationszeiten von zwei Wochen auf zwei Stunden: Faktor 25×. Doch Quellen offenbaren eine Lücke: Fehlerquoten, Sicherheitsfragen und Flops bleiben meist undokumentiert.

Dieser Artikel durchleuchtet fünf reale Szenarien für Agenturen. Er bewertet n8n plus LLMs anhand von Case Studies. Und nennt klar die Grenzen semi-autonomer Systeme. Grundlage: Technische Docs, Anbieterfälle und Blogs aus 2024–2025. Sie lernen, welche Prozesse messbaren ROI bringen. Und wo menschliche Kontrolle bleibt.

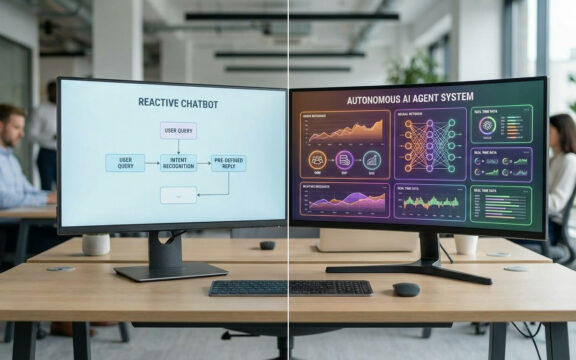

Was KI-Agenten technisch von Chatbots unterscheidet

„KI-Agent“ und „Chatbot“ klingen ähnlich. Technisch sind es Welten. Chatbots reagieren: Eingabe rein, Antwort raus. Fertig. Linear, plattformgebunden.

Architektur von KI-Agenten in n8n

n8n-Agents arbeiten nach Event-Trigger-Action mit Persistenz über Systeme hinweg. Konkret:

Autonome Workflow-Auslöser: Agents überwachen Quellen wie E-Mails, Webhooks oder Datenbankänderungen. Und starten Aktionen selbstständig. Beispiel: Neue E-Mail trifft ein. LLM-Node prüft Sentiment. Negativ? Priorisiertes Ticket in GitLab.

Multi-System-Orchestrierung: Chatbots bleiben in einer Plattform. n8n verbindet über 400 Nodes Systeme. Lead-Management könnte so laufen: Webformular-Webhook → CRM-Abfrage auf Duplikate → LLM-Qualifizierung → Slack an Sales → Calendly-Termin.

Vektordatenbank-Integration für RAG: Agents greifen via Retrieval-Augmented Generation auf Firmenwissen zu. Ablauf: Anfrage → Embedding → Vektorsuche → Kontext in Prompt → Antwort mit Quellen. Domänenspezifisch, unabhängig vom LLM-Training.

Der kritische Unterschied: Semi-Autonomie statt Vollautonomie

Quellen machen klar: „Autonome KI-Agenten“ sind semi-autonom. Belege:

- n8n integriert Fehler-Logging und Alerts – vorausgesetzt: Menschliche Überwachung.

- Sentiment-Analyse als Use Case. Ohne Fehlerquoten (Sarkasmus, Nuancen).

- Case Studies fordern Monitoring für kritische Flows. Kein „set and forget“.

Technisch: Automatisierte Entscheidungssysteme mit regelbasierter Eskalation. Keine selbstlernenden Einheiten. Mehr über den Unterschied zwischen KI-Agenten und Chatbots erfahren Sie in unserem detaillierten Vergleich.

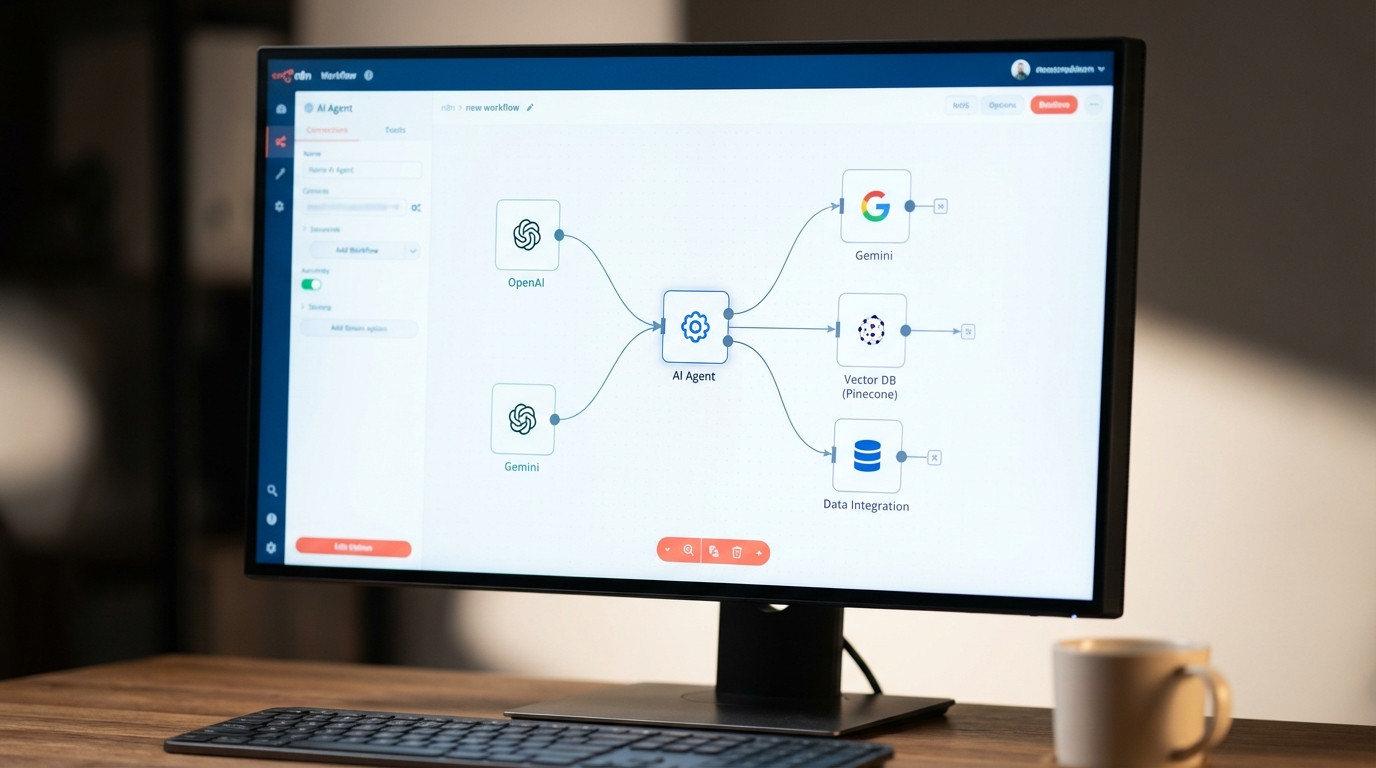

Der Tool-Stack für KI-Workflows in Agenturen

KI-Agents brauchen Workflow-Engine, LLM-Provider, Speicher und Ziele. Hier die Stack-Analyse aus dokumentierten Fällen:

Core-Komponenten des n8n-Stacks

n8n als Workflow-Engine

- Typ: Open-Source Low-Code-Plattform mit Self-Hosting.

- Interface: Visueller Drag-and-Drop-Editor. Standardfälle ohne Code.

- Deployment: Cloud oder On-Premise. Wichtig für DSGVO – Quellen bleiben vage.

- Integrationen: 400+ Nodes für CRM (Salesforce, HubSpot), E-Mail (Gmail, Postmark), Datenbanken (PostgreSQL, MongoDB), Ticketing (Jira, GitLab).

LLM-Nodes (Stand 2025)

Dedizierte Nodes binden Large Language Models ein:

- OpenAI GPT-4/GPT-4o: Reasoning, Sentiment, Content.

- Google Gemini: Multimodal (Text + Bild).

- Custom LLM-Endpoints: Eigene Modelle per API.

Aus Quellen: E-Mail-Triage (Dringlichkeit 0-10), Lead-Scoring, Key-Facts-Extraktion.

Vektordatenbanken für RAG

Kontextuelle Antworten: Vektordatenbanken speichern Embeddings.

- Pinecone, Weaviate, Qdrant: Dokumente → Chunking → Embedding (OpenAI ada-002) → Suche.

Quellen nennen es für Agent-Flows. Ohne Benchmarks zu Latenz oder Durchsatz.

Vergleich mit alternativen Stacks

Quellen vergleichen sparsam. n8n als „Zapier für Entwickler“: Flexibler, steilere Kurve. Benchmarks fehlen.

Erkennbare Unterschiede:

- Zapier/Make: GUI-stark, schneller Start, weniger Tiefe.

- n8n: Open Source, Self-Hosting, Custom Nodes.

- Enterprise (MuleSoft, Workato): Governance für Konzerne. Höhere Kosten.

5 konkrete KI-Workflow-Szenarien aus der Praxis

Diese Beispiele stammen aus dokumentierten Fällen. Sie zeigen Erfolge und Grenzen.

Beispiel 1: Datenintegration für Job-Portale (Stepstone)

Wer: Stepstone, europäisches Jobportal.

Ausgangssituation: APIs und Feeds integrieren? Früher Java/Springboot, Wochenlang.

Werkzeug/Methode: n8n mit API- und Transform-Nodes.

Implementierung:

- Webhook holt Stellenanzeigen-Daten.

- Normalisierung per JavaScript-Nodes.

- Validierung gegen Schema.

- Fehler? Benachrichtigung ans Data-Team.

- Valide? Direkt in Produktions-DB.

Ergebnis:

- Zeitersparnis: 25× (2 Stunden statt 2 Wochen).

- Skalierung: 200+ Flows produktiv.

- Ressourcen: 400+ Ingenieurwochen gespart.

- Stabilität: Mission-critical. Uptime? Undokumentiert.

Erkenntnis: Standardisierte Integrationen glänzen. „2 Stunden“ für Folgefälle nach Initialsetup.

Beispiel 2: E-Commerce Order-to-Delivery-Automatisierung

Wer: Anonyme E-Commerce-Firma (n8n-Case).

Werkzeug/Methode: n8n Multi-System-Flow.

Implementierung:

- Webhook bei neuer Bestellung (WooCommerce/Shopify).

- CRM-Abgleich auf Duplikate.

- PDF-Rechnung aus Template.

- E-Mail mit Tracking (Postmark).

- Status zurück ins Shop.

- Verzug? Erinnerung nach 7 Tagen.

Ergebnis:

- Umsatz: Sechsstellig monatlich (Zusammenhang unklar).

- Einrichtung: <2 Stunden Basis.

- Kunden: Mehr Transparenz.

Kritik: Anbieter-Case. Umsatz unkontrolliert. „<2 Stunden“ für Happy Path. Ignoriert Edge Cases, API-Ausfälle, DSGVO.

Erkenntnis: Lineare Transaktionen mit If-Then: Hoch effizient. Ausnahmen brauchen mehr Arbeit. Für WooCommerce-Shops bieten wir spezialisierte KI-Automatisierungen an.

Beispiel 3: E-Mail-Sentiment-Analyse mit automatischer Eskalation

Wer: Best-Practice-Beispiel (Tech-Blog).

Werkzeug/Methode: OpenAI-Node + Ticketing.

Implementierung:

- IMAP überwacht Postfach.

- Text extrahieren.

- LLM bewertet: „Stimmung 0-10 (0=verärgert)“.

- <3: High-Priority-Ticket in GitLab.

- 3-7: Standard.

- >7: Dankesmail optional.

Ergebnis:

- Sofort-Eskalation.

- Team fokussiert auf Dringendes.

Limitationen (technisch klar):

- False Positives bei Sarkasmus, Nuancen.

- Kein Thread-Kontext.

- Fehlerquote? Undokumentiert.

Erkenntnis: Triage gut. Finale Entscheidungen? Menschlich. Review-Schleife empfohlen.

Beispiel 4: Lead-Management mit CRM-Synchronisation

Anwendungsfall: Lead-Erfassung für Agenturen.

Workflow:

- Formular → Webhook.

- CRM-Query auf Duplikate.

- LLM: „Conversion 0-100%?“.

- Score ins CRM-Feld.

- >70%: Slack-Alarm.

- 30-70%: Drip-Kampagne.

- <30%: Newsletter.

Erwartetes Ergebnis:

- Schnelle High-Intent-Reaktion.

- Weniger manuelle Qualifizierung.

- Keine verpassten Leads.

Offene Fragen:

- LLM-Genauigkeit vs. Mensch?

- False Negatives?

- Kosten pro Lead (API-Calls)?

Erkenntnis: Unterstützt Entscheidungen. Aber als Ersatz riskant ohne eine Validierung.

Beispiel 5: Content-Erstellung mit Datenanalyse

Anwendungsfall: Automatische Reports.

Workflow:

- Cronjob täglich 9 Uhr.

- APIs abfragen (Analytics, CRM, Ads).

- Aggregation in n8n.

- LLM-Summary: „3 Trends, max. 150 Wörter“.

- PDF mit Charts.

- Mail ans Management.

Ergebnis:

- Tägliche Reports ohne Aufwand.

- Konsistentes Format.

- 30 Minuten/Tag gespart.

Limitation:

- Kein Kausalwissen.

- Halluzinationen bei Zahlen.

- Datenqualität unkritisch.

Erkenntnis: Deskriptive Zusammenfassungen. Strategie? Nein.

Realistische Erwartungen: Was automatisierbar ist (und was nicht)

Case Studies zeichnen ein Muster: Strukturierte, ambiguitätsarme Prozesse gewinnen. Systematisierung:

Gut automatisierbar (hohe Erfolgswahrscheinlichkeit)

Kategorie 1: Datenintegration & Transformation

- API-zu-API mit Schemas.

- Normalisierung.

- ETL.

- Beispiel: Stepstone (25×).

Kategorie 2: Transaktionale Prozesse

- Orders ohne Komplexität.

- PDF aus Templates.

- Standard-Mails.

- Beispiel: E-Commerce.

Kategorie 3: Monitoring & Alerting

- Logs mit Schwellen.

- Status-Checks.

- Eskalationsregeln.

Bedingt automatisierbar (erfordert Supervision)

Kategorie 4: Sentiment & Classification

- Triage, Scoring.

- Caveat: Fehler unvermeidbar.

- Empfehlung: LLM vorschlagen, Mensch entscheiden.

Kategorie 5: Content-Generierung

- Summaries aus Daten.

- FAQ-Antworten.

- Caveat: Halluzinationen, Fact-Check nötig.

Schwer automatisierbar (hohe Fehlerrisiken)

Kategorie 6: Komplexe Entscheidungsfindung

- Priorisierung.

- Konflikte.

- Qualitative Bewertung.

- Grund: Kein Kausalverständnis.

Kategorie 7: Prozesse mit vielen Edge Cases

- Komplexer Support.

- Verträge.

- Beratung.

- Grund: Haftung, Ausnahmen.

Kategorie 8: Kreative & strategische Aufgaben

- Markenstrategie.

- Innovation.

- Design.

- Grund: LLMs auf Durchschnitt getrimmt.

Implementation Effort & ROI-Betrachtung

Quellen geben ROI fragmentarisch. Realistische Einschätzung:

Setup-Zeit nach Komplexität

| Workflow-Typ | Erstimplementierung | Iteration/Anpassung | Skills benötigt |

|---|---|---|---|

| Einfach (Single API → E-Mail) | 1-3 Stunden | 15-30 Min | API-Grundverständnis |

| Mittel (Multi-System, einfache Logik) | 1-2 Tage | 1-2 Stunden | JSON/REST-Kenntnisse |

| Komplex (LLM + Vektordatenbank + Custom Logic) | 1-2 Wochen | 1 Tag | Prompt Engineering, Debugging |

| Enterprise (Governance, Security, Skalierung) | 4-8 Wochen | Projektabhängig | DevOps, Security-Audit |

„2 Stunden“ aus Stepstone: Einfache Folgeintegrationen.

Kostenstruktur (nicht in Quellen detailliert)

Typische Faktoren:

- n8n Hosting: Self-Hosted (Infra) vs. Cloud (Subscription).

- LLM-API: GPT-4 ~0,03 $/1K Tokens. Relevant bei Volumen.

- Entwicklerzeit: Initial + Wartung.

- Fehlerkosten: Geschäftsschäden.

Messbare Effizienzgewinne (aus Case Studies)

Stepstone:

- 25× Integration.

- 400+ Wochen gespart.

- ROI (geschätzt): Bei 100K €/Ingenieur/Jahr: 8M+ €.

E-Commerce:

- Sechsstelliger Umsatz (unkontrolliert).

- <2 Stunden.

- Kritik: Vanity ohne Kostenrechnung.

Lead-Management:

- 100 Leads/Monat: 25 Stunden manuell.

- Automatisiert: 2 Std. Setup + 1 Std./Monat.

- ROI: Ab Monat 2.

Langzeitwartung (nicht in Quellen dokumentiert)

Offen: API-Changes? Monitoring bei 200+ Flows? Governance?

Grenzen und Fehlerquellen in der Praxis

Quellen ignorieren Fehlerquoten, Flops, Security. Ableitbare Risiken:

Systemische Fehlerquellen

1. LLM-Halluzinationen

- Plausible Falschheiten.

- Kritisch: Scoring, Analyse.

- Abhilfe: Fallbacks, Confidence-Scores.

2. API-Rate-Limits & Timeouts

- Limits, Ausfälle.

- Kritisch: Hohes Volumen.

- Abhilfe: Retry, Backoff (n8n-ready).

3. Schema-Changes

- Strukturwechsel.

- Abhilfe: Validierung, Monitoring.

4. Kontext-Verlust bei LLMs

- Kein Thread.

- Abhilfe: Kontext injizieren.

Organisatorische Fehlerquellen

5. „Set and Forget“

- Statische Flows bei wandelnden Prozessen.

- Abhilfe: Quartalsaudits.

6. Fehlende Dokumentation

- Keine Kommentare.

- Abhilfe: Notiz-Nodes nutzen.

7. Unklare Verantwortlichkeiten

- Wer bei Fehlern?

- Abhilfe: Eskalationspfade.

Sicherheits- und Compliance-Risiken (nicht in Quellen behandelt)

DSGVO? Undokumentiert. Fragen: API-Keys? LLM-Server (US)? Logging?

Empfehlung:

- Self-Hosted n8n (EU).

- EU-LLMs (Ollama).

- Anonymisierung vor Processing.

Strategische Einordnung: Wann lohnt sich der Einsatz?

n8n + LLMs boosten standardisierte, frequent Prozesse. Entscheidung an drei Faktoren:

Entscheidungsmatrix

Faktor 1: Prozessvolumen

- High (100+/Tag): ROI Monat 1-2.

- Medium (10-100): Quartal.

- Low (<10): Fraglich.

Faktor 2: Prozessstandardisierung

- Hoch (80%+): Ideal.

- Mittel: Human-in-the-Loop.

- Niedrig: Ineffizient.

Faktor 3: Fehlertoleranz

- Hoch: Aggressiv.

- Mittel: Supervised.

- Niedrig: Nur Assistenz.

Use-Case-Priorisierung für Agenturen

Quick Wins (<1 Tag, ROI <1 Monat):

- Leads → CRM.

- Bestätigungs-Mails.

- Daily Reports.

Strategic Plays (1-2 Wochen, 3-6 Monate):

- E-Mail-Sentiment.

- Lead-Scoring.

- Order-Processing.

Advanced (4+ Wochen, 6-12 Monate):

- RAG-Knowledge.

- Komplexe Integration.

- Predictive mit LLM.

FAQ

Sind KI-Agenten in n8n wirklich autonom?

Nein. Quellen belegen semi-autonome Systeme. Keine lernenden Einheiten ohne Input. Regelbasierte Flows mit probabilistischen LLMs. Alerts zeigen: Mensch dabei. Empfehlung: Human-in-the-Loop für Kritik.

Wie schnell kann ich einen KI-Workflow produktiv nutzen?

„2 Stunden“ gilt für Folgeintegrationen. Real: Einfach 1-3 Std., Mittel 1-2 Tage, Komplex 1-2 Wochen, Enterprise 4-8 Wochen. Voraussetzung: Klare Specs, APIs bereit. Edge Cases verdoppeln Zeit.

Welche Fehlerquote haben KI-Agenten im Praxiseinsatz?

Unbeantwortbar. Keine Daten zu Raten oder Ausfällen. Stepstone: Stabil, metrikfrei. LLMs: 5-15% Halluzinationen. Monitoring essenziell. Tracken Sie 3 Monate selbst.

Wie unterscheidet sich n8n von Zapier oder Make?

n8n: „Zapier für Entwickler“. Open Source, Custom Nodes, Tiefe. Zapier: GUI, Non-Tech-freundlich. n8n für Komplexes überlegen. Pricing? Undokumentiert.

Welche technischen Skills brauche ich für n8n-Workflows?

Einfach: API-Basics. Mittel: JSON, HTTP-Debug. Fortgeschritten: JS, Prompts, Vektors. Enterprise: DevOps. Starten Sie mit Templates. Debugging braucht API-Erfahrung.

Kann ich n8n mit proprietären Unternehmensdaten DSGVO-konform nutzen?

Quellen schweigen dazu. Machbar: Self-Hosted (EU), EU-LLMs, Anonymisierung. Legal-Review vor Kundendaten. Cloud? Risiken prüfen.

Was passiert, wenn ein Workflow fehlschlägt?

Logging, Alerts, Routing zu Error-Pfaden. Retry, Tickets. Bei Scale: Extra-Tools wie Sentry. Definieren Sie Prozesse: Wöchentliches Review.

Lohnt sich n8n für kleine Agenturen (<10 Mitarbeiter)?

Ja, bei Quick Wins (10-20/Tag). 5-10 Std./Monat gespart: 250-1.000 €. Break-Even Monat 2-3. Skills entscheidend. Cloud zum Start, DSGVO checken.

Fazit: Semi-Autonomie mit messbarem ROI – bei realistischen Erwartungen

KI-Workflows für Agenturen: Pragmatik statt Hype. n8n + LLMs boosten standardisierte Prozesse. Keine Vollautonomie.

Drei Erkenntnisse:

1. Bewiesene Effizienzgewinne in spezifischen Szenarien

Stepstone: 25×, 400+ Wochen. E-Commerce: <2 Std. Für Repetition mit Regeln.

2. Kritische Datenlücken bei Fehlerquoten und Compliance

Keine Raten, keine DSGVO-Details. Tracken Sie selbst. Legal vorab.

3. Semi-Autonomie erfordert Supervision

Design mit Alerts. LLMs probabilistisch. Vorschlag + Mensch.

Empfehlung: Quick Wins priorisieren. Error-Handling von Anfang. Eval nach 3 Monaten. Möglichkeiten da. Erfolg braucht Realismus und Monitoring. „Autonome Agenten“? Noch Marketing für Regel-Systeme.

Für professionelle Umsetzung in WordPress- oder WooCommerce-Projekten unterstützen wir Sie mit maßgeschneiderten Automatisierungslösungen. Mehr zu intelligenten E-Commerce-Systemen erfahren Sie in unserem Guide zu KI-gestützten Produktempfehlungen.