KI-Coding-Tools locken mit Produktivitätssteigerungen von 50-100%. Viele Entwickler stolpern jedoch über vage Prompts, die mittelmäßige Ergebnisse liefern. Ein Monster-Task wie „Baue mir eine vollständige E-Commerce-Integration“ spuckt generische Lösungen aus. Die Nacharbeit frisst oft mehr Zeit als reines Handcoding. KI-Modelle werden bei Komplexem zu Generalisten: Sie interpretieren statt präzise auszuführen.

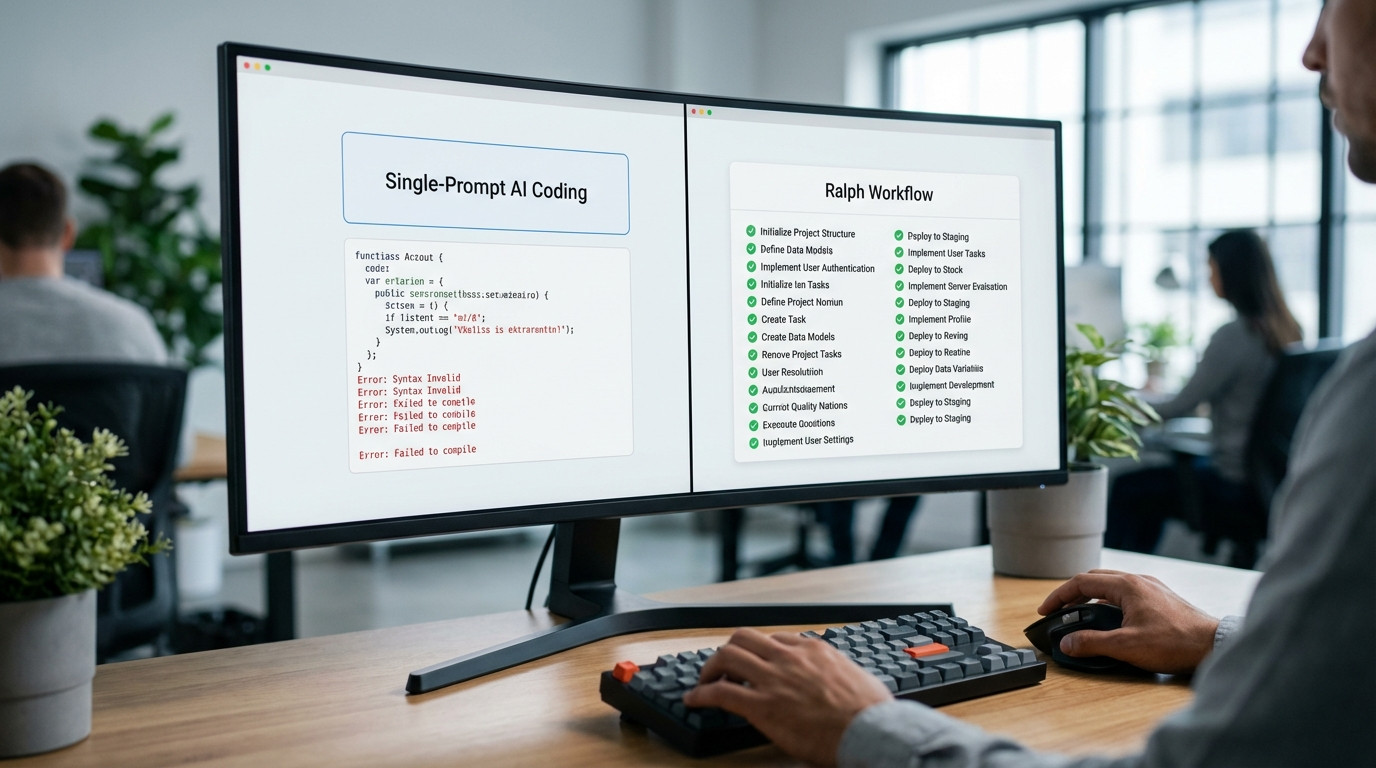

Das Ralph AI Workflow kehrt das um. Benannt nach dem simplen Cartoon-Kind, zerlegt es Projekte in kleine, überprüfbare Tasks mit klaren Pass/Fail-Kriterien. Statt eines Riesen-Prompts kriegt die KI 30-50 atomare Aufgaben – nacheinander, mit Check nach jedem Schritt. Anthropic-CEO Dario Amodei sagte Anfang 2025: Viele seiner Entwickler tippen keinen Code mehr selbst. Sie steuern KI-Modelle wie Claude Code task-basiert.

Dieser Artikel erklärt den Ralph AI Workflow. Er listet 2025 einsatzbereite Tools auf und realen Produktivitätsgewinn aus Cases. Sie lernen den Unterschied zu klassischem AI-Coding, wann task-basierte KI scheitert und wie Iterationen mit GitHub Copilot, Cursor oder Claude passen. Alles basiert auf 2025er Cases – kein Hype.

Was ist das Ralph-Prinzip und wie unterscheidet es sich von klassischem AI-Coding?

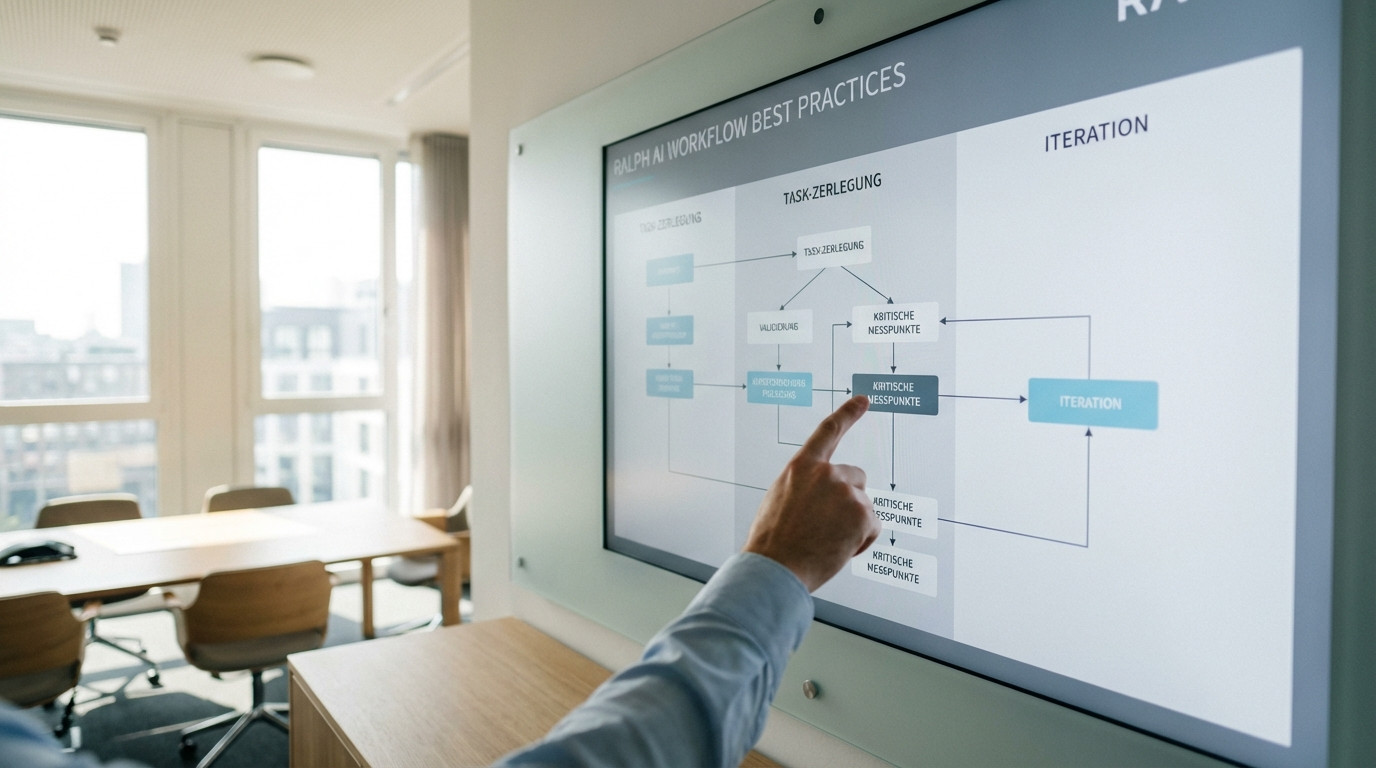

Definition: Task-Zerlegung mit pass/fail-Kriterien

Das Ralph-Prinzip zerlegt komplexe Software-Projekte in granulare Tasks. Jeder Task bekommt:

- Klare Erfolgskriterien: Messbare Bedingungen (z.B. „API-Endpoint liefert JSON mit Status 200“)

- Iterative Überprüfung: Check nach jedem Task, ob Kriterien erfüllt sind

- Autonome Ausführung: KI-Agenten arbeiten Tasks sequentiell ab, ohne Eingriffe

Statt „Entwickle ein WordPress-Plugin für Newsletter-Automation“ folgt eine Kette von 30-40 Tasks:

- Erstelle Plugin-Header mit korrekter Namespace-Deklaration

- Implementiere Aktivierungs-Hook, der Datenbank-Tabelle anlegt

- Baue Admin-Panel mit Menüeintrag unter „Einstellungen“

- Erstelle REST-Endpunkt für Subscriber-Registrierung

Jeder Task endet binär: Es funktioniert. Oder nicht. Kein Raum für Interpretationen, die bei großen Prompts Unpräzisionen schaffen.

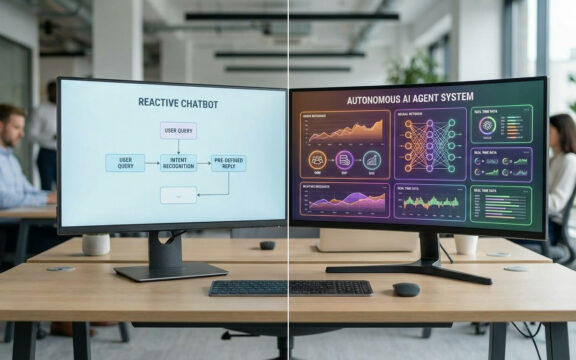

Abgrenzung zu Single-Prompt Coding

Klassisches AI-Coding mit GitHub Copilot oder ChatGPT nutzt große Kontextfenster. Entwickler fassen Anforderungen zusammen und die KI spuckt Dateien oder Module aus. Das Problem: Bei Komplexem entsteht Generalisten-Code – funktional, aber nicht optimal für den Use Case.

Eine Analyse im todo:cast Developer-Podcast zeigt: Viele überschätzen KI-Gewinne. Erwartung prallt auf Realität – Nacharbeit frisst Zeit. Ars Technica berichtete: KI-Agenten erzeugen in Fällen mehr Arbeit, als sie sparen. Besonders bei unklaren Spetifikationen.

Ralph AI spezialisiert. Kleine Tasks zwingen die KI zum Spezialisieren pro Funktion. Ergebnis: Präziserer Code, weniger Nachbesserung.

Technische Grundlage: Agentic AI 2025

Task-basierte Workflows basieren auf Agentic AI – Systemen, die Ketten autonom abarbeiten. 2025 sind Tools marktreif:

- Claude Code (Anthropic): ~25% Marktanteil bei AI-Coding-Tools, optimiert für Iterationen

- Cursor (Anysphere): Web-Interface mit CLI-Version für Agent-Chains

- Gemini CLI (Google): Open-Source-Klon von Claude Code, Python-basiert

Dario Amodei prognostizierte: KI generiert in 6-12 Monaten 80-100% Code. Voraussetzung: Granulare Task-Zerlegung. Ohne bleibt der Gewinn bei 30-50%.

Warum scheitern große KI-Tasks ohne klare Erfolgskriterien?

Das Generalisten-Problem

KI-Modelle abstrahieren Muster aus Massendaten. Bei Vagem wählen sie den „durchschnittlichen“ Weg. Praxisbeispiel:

Prompt: „Baue eine Authentifizierung für meine App.“

KI-Output: Standard-JWT mit Session-Storage – ignoriert bestehende OAuth2-Infrastruktur.

Der Entwickler refaktoriert nachträglich. Salesforce-Fall im todo:cast Podcast: Ihr KI-Agent schafft 30% Arbeit – dank vordefinierter Kleintasks. Große Tasks: Erfolgsrate unter 50%.

Fehlende Messbarkeit

Ohne binäre Kriterien validiert die KI ihre Ausgabe nicht selbst. Bei „Implementiere Datenbankschicht“ fehlt Klarheit:

- Welches ORM? Welche DB (SQL/NoSQL)?

- Migrations-Support?

- Connection-Pooling?

- Error-Handling?

KI nimmt Annahmen. Fehler zeigen sich erst im Integrationstest. Ralph fordert stattdessen:

Task 1: Erstelle Prisma-Schema für Benutzer-Tabelle (Felder: id, email, password_hash)

Kriterium: Schema valide, prisma generate ohne Fehler.

Task 2: Implementiere CRUD-Operations für User-Model

Kriterium: Unit-Tests laufen (100% Coverage).

Jeder Task testbar isoliert. Scheitern stoppt die Kette – kein Müllcode.

Drift-Effekt bei langen Prompts

KI-Insights Blog (Entwickler des Ralph-Briefing Agents): Bei großen Kontexten driftet die KI nach 500-1000 Codezeilen ab. Variablennamen werden inkonsistent, Muster wechseln.

Kleine Tasks (50-150 Zeilen) verhindern das. Frischer Prompt pro Task hält Fokus.

Für welche Arten von Projekten eignet sich das Ralph-Modell besonders?

Prototyping und MVPs

KI-Insights Blog: StreamDeck Icon Generator in 35 Iterationen von Idee zu Prototyp. Alle 5-15 Minuten, Workflow über Nacht.

Prototyping gewinnt durch Ralph, weil:

- Schnelle Validierung: Nach 10 Tasks nutzbarer Kern

- Pivot-Fähigkeit: Scheitern kostet 2-3 Tasks

- Overnight-Modus: Tasks abends definieren, morgens Code da

Ideal für Builder mit n8n, Zapier oder Make.com. KI liefert Custom-Code-Snippets für Workflows.

Feature-Building in bestehender Codebasis

Optimal für inkrementelle Features, nicht Greenfield. Beispiel:

Projekt: WooCommerce-Shop mit Custom-Subscription-Logik

Funktionswunsch: Automatische Upgrade-Prompts bei Premium-Features

Task-Zerlegung:

- Analysiere Subscription-Klasse, finde Hook-Points

- Erstelle Event-Listener für Premium-Zugriff

- Implementiere Prompt-UI als React-Komponente

- Baue Backend-Endpoint für Upgrade-Trigger

- Schreibe Integration-Tests mit Checkout-Logik

KI greift nur Interfaces – keine volle Codebase. Wer WooCommerce Shops für Kleinunternehmen betreut, spart hier Entwicklungszeit bei Custom-Features.

Repetitive, modulare Tasks

Ralph glänzt bei Repetition:

- API-Wrapper: 20 Endpoints mit gleicher Auth

- CRUD-Interfaces: Dutzende Modelle

- Migrationen: 50+ DB-Änderungen

Pattern als Template definieren, KI repliziert. Salesforce sparte laut todo:cast 9 Entwickler – ~€10.000/Monat.

Grenzen: Architekturentscheidungen und kreative Problemlösung

Ralph scheitert bei:

- System-Design: Microservices? State-Management? (Mensch entscheidet)

- Performance-Optimierung: Bottlenecks zu komplex

- Unklare Requirements: Keine klare Vision

Wie lassen sich Task-basierte KI-Iterationen mit bestehenden Tools kombinieren?

Integration mit Claude Code und Cursor

Beide unterstützen task-basierte Workflows nativ:

Claude Code (Anthropic):

- API über CLI:

claude-code exec --task "task_description" --validate "test_command" - Pass/Fail per Exit-Codes: Erfolg bei 0

- Chain-Modus: Tasks aus YAML sequentiell

Cursor (Anysphere):

- Web-Interface für Task-Definition

- GitHub Actions-Integration: Tasks als CI/CD-Steps

- Collaborative Mode: Parallele Chains

Beispiel-YAML für Claude Code:

tasks:

- id: 1

description: "Create Prisma schema for User model"

validation: "npx prisma generate"

success_criteria: "exit_code == 0"

- id: 2

description: "Implement CRUD operations"

validation: "npm test -- user.test.ts"

success_criteria: "coverage >= 100%"

GitHub Copilot als Hybrid-Ansatz

Copilot ist kein Agent, aber task-fähig:

- Pair-Programming: Kommentare als Tasks, Copilot generiert

- Test-Driven: Test schreiben, Copilot implementiert

todo:cast: Viele nutzen Copilot als Spezialist pro Funktion. Ralph manuell.

CLI-Chains mit Gemini CLI

Gemini CLI als Open-Source-Alternative:

# Task-Chain via Bash-Script

for task in $(cat tasks.json | jq -r '.[] | @base64'); do

_task=$(echo $task | base64 -d)

description=$(echo $_task | jq -r '.description')

validation=$(echo $_task | jq -r '.validation')

gemini-cli generate --prompt "$description" > output.py

eval $validation || exit 1

done

Vorteil: Volle Kontrolle, kein Lock-in. Nachteil: Scripting nötig.

n8n/Zapier/Make.com Integration

Für Builder ohne CLI:

- n8n: HTTP-Requests an Claude/Gemini APIs, Tasks als Nodes

- Zapier: Code-Step für Validation

- Make.com: Iterator für Chains

Beispiel-Workflow (n8n):

- Webhook: Task-Liste als JSON

- Loop: Über Tasks iterieren

- HTTP Request: Task an Claude API

- Code Node: Validation ausführen

- IF-Node: Fehler → Stop, Erfolg → Next

Medialine Blog: Agenturen bauen 2025 Client-Projekte so. Automatisierung greift auch bei der WordPress Wartung durch automatisierte Workflows.

Welche realen Produktivitätsgewinne berichten Anwender?

Fallstudie 1: StreamDeck Icon Generator (KI-Insights Blog)

Wer: KI-Insights Blog (Autor mit 30+ Jahren Tech-Erfahrung)

Werkzeug/Methode: Ralph-Briefing Agent (Eigenentwicklung, Beta 2025)

Anwendungsfall: Prototyp für automatisierte StreamDeck-Icons

Ergebnis:

- 35 Iterationen von Konzept zu Prototyp

- Gesamtdauer: ~8 Stunden (über Nacht, unbeaufsichtigt)

- Manuelle Nacharbeit: 2 Stunden für UI-Polishing

Erkenntnis: Pass/Fail-Kriterien exakt definieren. Vage („Icon soll gut aussehen“) führte zu Drift. Messbar („72x72px, PNG, Transparenz“) ermöglichte Autonomie.

Fallstudie 2: Anthropic-Entwickler (Dario Amodei, WEF 2025)

Wer: Anthropic-Team (Claude-Hersteller)

Werkzeug/Methode: Claude Code (interne Version)

Anwendungsfall: Feature-Code für Claude selbst

Ergebnis:

- Entwickler schreiben keinen Code mehr (Amodei-Zitat)

- Prognose: 80-100% Code-Generierung in 6-12 Monaten

- Produktivitätsplus implizit durch Rollenwechsel zu „Prompt Engineers“

Erkenntnis: Nur mit Task-Zerlegung. Große Prompts scheitern selbst bei Claude.

Fallstudie 3: Salesforce AI Agent (todo:cast Podcast)

Wer: Salesforce (interne Automatisierung)

Werkzeug/Methode: Eigener KI-Agent

Anwendungsfall: Coding-Tasks im Salesforce-Ökosystem

Ergebnis:

- 30% der Entwicklungsarbeit automatisiert

- Äquivalent zu 9 Software-Entwicklern

- Kostenersparnis: ~€10.000/Monat (bei €110k Gehalt)

Herausforderung: Unklare Anforderungen erzeugen Mehraufwand. Aufgaben nachschärfen war nötig.

Benchmark-Zusammenfassung

Basierend auf 2025-Daten:

| Metrik | Wert | Quelle |

|---|---|---|

| Zeitersparnis Prototyping | 30-50% | KI-Insights, Anthropic |

| Code-Generierung (aktuell) | 30% | Salesforce |

| Code-Generierung (Prognose 2026) | 80-100% | Anthropic (Amodei) |

| Iterationsgeschwindigkeit | 5-15 Min/Task | KI-Insights |

| Kosteneinsparung | ~€10k/Monat (9 FTEs) | Salesforce |

Wichtig: Gains brauchen granulare Zerlegung. Ohne Ralph: 10-20% (Stack Overflow Survey 2025).

Tools & Ressourcen für Ralph AI Workflows

Verfügbare Plattformen (2025)

| Tool | Preis | Pros | Cons | Best For |

|---|---|---|---|---|

| Claude Code | Beta (kostenlos) | Nativ task-basiert, API-Access | Noch keine Pro-Version | Entwickler mit CLI-Kenntnissen |

| Cursor | €20/Monat | Web-UI, GitHub-Integration | Vendor-Lock-in | Teams ohne Terminal |

| Gemini CLI | Open-Source | Volle Kontrolle, Python-basiert | Scripting nötig | DevOps, Automatisierer |

| GitHub Copilot | €10/Monat | IDE-Integration | Kein autonomer Agent | Hybrid (Pair Programming) |

| Ralph-Briefing Agent | Beta (kostenlos) | Prototyping-spezialisiert | Begrenzte Fälle | Builder, Rapid Prototyping |

System-Requirements

Minimal:

- Python 3.9+ (für CLI-Werkzeuge)

- Node.js 18+ (für JS-Agents)

- 8 GB RAM (lokale Modelle)

- API-Keys (Claude, OpenAI, Gemini)

Empfohlen:

- 16 GB RAM (parallele Tasks)

- SSD (schnelle I/O)

- CI/CD (GitHub Actions) für Validation

Best Practices für Task-Zerlegung

1. Atomarität: <150 Zeilen Code pro Task

2. Messbarkeit: Binäre Kriterien (Tests, Linter, Benchmarks)

3. Isolierung: Keine impliziten Abhängigkeiten

4. Dokumentation: Kontext pro Task (Problem lösen?)

Beispiel-Template:

task:

id: 42

title: "Implement rate limiting middleware"

context: "API currently has no rate limits, causing abuse"

acceptance_criteria:

- "Returns 429 status after 100 requests/minute"

- "Uses Redis for distributed counting"

- "Integration tests pass (test/rate-limit.test.ts)"

estimated_loc: 80

dependencies: [task_41] # Redis setup

Die Debatte: Überschätzt KI die Produktivität bei Coding-Tasks?

Position A: Hohe Produktivität durch task-basierte Agenten

Vertreter: Dario Amodei, Salesforce, KI-Insights Blog

Argumente:

- Cases: 30-50% Zeitersparnis

- Anthropic: Vollständig KI-gestützt

- Prognose: 80-100% in 12 Monaten

Evidenz:

- WEF 2025 (Amodei)

- Salesforce: 30%, 9 FTEs

- StreamDeck: 35 Iterationen overnight

Position B: Oft überschätzt, führt zu mehr Arbeit

Vertreter: Ars Technica, Stack Overflow Survey 2025, todo:cast

Argumente:

- Unklare Specs: Mehr Nacharbeit

- Survey: Erwartung vs. Realität

- Validation-Stress

Evidenz:

- Ars: „Mehr Arbeit“ (Praxisberichte)

- Survey-Daten

- Salesforce: Nur 30%

Einordnung: Beide Ansätze haben Berechtigung

Konsens:

- Kleine Tasks: Granulare Zerlegung wirkt

- Große Tasks: Single-Prompts scheitern

Divergenz:

- Prognosen: A optimistisch, B hype-warnend

- Fälle: A ideal, B real mit Unklarheiten

Empfehlung:

Task-Design-Erfahrene holen 30-50% raus. Teams ohne Prozesse riskieren Mehraufwand. Schlüssel: Zerlegungs-Disziplin.

Strategische Einordnung: Business Value für Entwickler und Builder

ROI-Betrachtung

Zeitersparnis:

- Prototyping: 30-50% (KI-Insights)

- Feature-Building: 30% (Salesforce)

- Overnight: 8 Stunden unbeaufsichtigt (StreamDeck)

Kostenreduktion:

- Personalkosten: ~€10.000/Monat (9 FTEs)

- Werkzeugkosten: €0-20/Monat

- Opportunitätskosten: 2-3x mehr Prototypen

Risikominimierung:

- Frühes Stoppen: Bei Fehlern

- Weniger Schulden: Wartbarer Code

- Kein Lock-in: Open-Source-Optionen

Wettbewerbsvorteil für Builder

Marktdifferenzierung:

- Speed-to-Market: Prototypen in 1-2 Tagen

- Pitches: Demos statt Mockups

- Skalierung: n8n-Workflows mit Custom-Code

Beispiel (Agentur, 10 Entwickler):

- Ohne Ralph: 10 × €100k = €1M/Jahr

- Mit 30% Gain: 7 × €100k = €700k/Jahr

- Werkzeugkosten: €2.400/Jahr

- Netto: €297.600/Jahr

(Vereinfacht; abhängig von Projekten)

Implementation Effort

Zeit:

- Einrichtung: 2-4 Stunden (Keys, CLI, Templates)

- Einarbeitung: 1-2 Wochen (Task-Patterns)

- Erste Projekte: 5-10 Prototypen

Kosten:

- Gratis: Claude Beta, Gemini CLI

- Paid: Cursor (€20/Monat)

- Enterprise: Anthropic API (~€0.01/1k Tokens)

Kenntnisse:

- Basic: Prompting, Unit-Tests

- Intermediate: YAML/JSON, CLI

- Advanced: CI/CD, Scripting

Risiko:

- Niedrig: Prototyping

- Mittel: Features in Prod (Reviews)

- Hoch: Kritische Infra (Oversight)

Fazit: Ralph-Prinzip als Produktivitätshebel für task-fähige Entwickler

Key Takeaways

1. Task-Zerlegung ist entscheidend: <150-Zeilen-Tasks mit binären Kriterien. Ralph AI Workflow braucht Disziplin – kein Plug-and-Play.

2. Gains bei 30-50%, nicht 100%: Salesforce 30%, KI-Insights 50% Prototyping. 80-100% (Amodei) ambitioniert für 2026, nur bei Perfektion.

3. Tools marktreif: Claude Code, Cursor, Gemini CLI. Builder starten via n8n/Make.com.

4. Kein Ersatz für Strategie: Design, Optimierung, Kreativität bleiben menschlich. Ralph boostet Routine um Faktor 2-3. Die strategische Planung ist wichtig, ähnlich wie bei SEO für Kleinunternehmen – Technik allein reicht nicht.

Handlungsempfehlung

Entwickler:

Starten Sie mit Prototyp (CLI-Tool, Wrapper). 20-30 Tasks mit Tests. Claude/Gemini Beta (gratis).

Builder:

Claude API in n8n. Custom-Snippets für Automatisierungen.

Agenturen:

Intern testen. Teams schulen. 30% Gain kalkulieren.

Realitäts-Check

Ralph ist kein Autopilot. Arbeit wandert zu Task-Definition und Validation. Ars Technica: Schlechte Tasks multiplizieren Probleme. Gewinn hängt von Spezifikationsqualität ab.

Test-Driven-Entwickler mit klaren Requirements profitieren. Vage Ideen? KI verschärft Chaos.

Technik bereit 2025. Sind Ihre Prozesse task-fähig?

FAQ

Was unterscheidet Ralph-Workflows von normalen GitHub Copilot Prompts?

GitHub Copilot autocomplettiert im Editor auf Kommentare oder Kontext. Ralph-Chains laufen autonom mit Pass/Fail – 30-50 Tasks overnight. Copilot braucht Input pro Schritt, Ralph baut Features ohne. Kombinierbar: Copilot für Funktionen, Ralph für Orchestrierung.

Kann ich Ralph-Workflows ohne Terminal-Zugang (z.B. nur mit n8n) nutzen?

Ja, via HTTP-APIs. Claude/Gemini REST in n8n-Nodes. JSON-Array loopern, Code-Nodes validieren. Flexibilität geringer, reicht für 80% (Wrappers, Transformationen). Medialine Blog: Agenturen für Client-Automations.

Wie vermeide ich, dass die KI bei langen Task-Chains „driftet“?

Drift durch Vagem oder fehlende Abhängigkeiten. Maßnahmen: (1) Atomare Kriterien. (2) Dependencies deklarieren. (3) <150 Zeilen/Task. (4) Review alle 10 Tasks. KI-Insights: Messbare Kriterien („72x72px PNG“) eliminierten Drift.

Welche Projektgröße rechtfertigt den Setup-Aufwand für Ralph-Workflows?

Ab ~20 Stunden. Kleine Scripts: Copilot/ChatGPT. Salesforce: 18.000 Stunden/Jahr. Bei 40-Stunden-Prototyp: 12-20 Stunden gespart. Faustregel: >15 Module – Ralph effizienter.

Ersetzt das Ralph-Prinzip Entwickler oder macht es sie nur produktiver?

Produktiver bei Routine (2-3x). Amodei: Kein eigenes Codieren mehr – stattdessen Tasks/Reviews/Design. Salesforce: 9 weniger, umverteilt. Russell: Strategie nicht taskbar. Implementation automatisiert, Innovation nicht.

Welche versteckten Kosten entstehen bei KI-basierten Workflows?

(1) API: ~€1/Run (50 Tasks). (2) Einarbeitung: 1-2 Wochen (~€2.000). (3) Reviews: ~20% Zeit. (4) Infra: CI/CD-Setup. todo:cast: Netto 20% nach Overhead.

Funktioniert Ralph-Zerlegung auch für Non-Coding-Tasks (z.B. Content, Design)?

Ja, bei messbaren Kriterien. Content: Word-Count, Keywords. Design: Wireframe-Specs. Grenze: Subjektives („modern wirken“). FLUX.1: 8x Iterationen bei Parametern. Checkliste-tauglich = machbar.

Wie gehe ich mit gescheiterten Tasks um, ohne die gesamte Chain zu verwerfen?

Retry mit Limits: Error als Kontext, 3 Versuche, dann Review. --retry 3 in Tools. Fallbacks definieren. StreamDeck: Fail-Fast, morgens Logs fixen, Neustart. Verhindert Aufbau auf Fehlern.